Автогенерация robots.txt

Файлы robots.txt и sitemap.xml – это самые важные для SEO-продвижения файлы сайта. В них содержатся команды для поисковых роботов. Благодаря им они понимают, какие страницы индексировать, а какие нет.

Эти файлы создаются администратором сайта. Подробности читайте в документации 1С-Битрикс:

Генератор robots.txt

Генерация файла карты сайта

Далее вам нужно сгенерировать эти же файлы для каждого региона. Обычно файлы robots.txt и sitemap.xml для различных регионов создаются, настраиваются и редактируются вручную. В Аспро: Корпоративный сайт 2.0 реализована возможность автоматической генерации файлов. Это принципиально новое решение задачи, которое позволит вам сэкономить время SEO-специалиста и сократить количество ошибок, которые возможны при ручном создании robots.txt и sitemap.xml под каждый регион. Рассмотрим, как работает этот функционал, и как с его помощью научиться автоматически генерировать нужные файлы.

После того, как вы создали файлы robots.txt и sitemap.xml для основного домена, инструкции из них можно продублировать в файлы, настраивающие доступ поисковых роботов к поддоменам. И здесь вам понадобится функция генерации файлов.

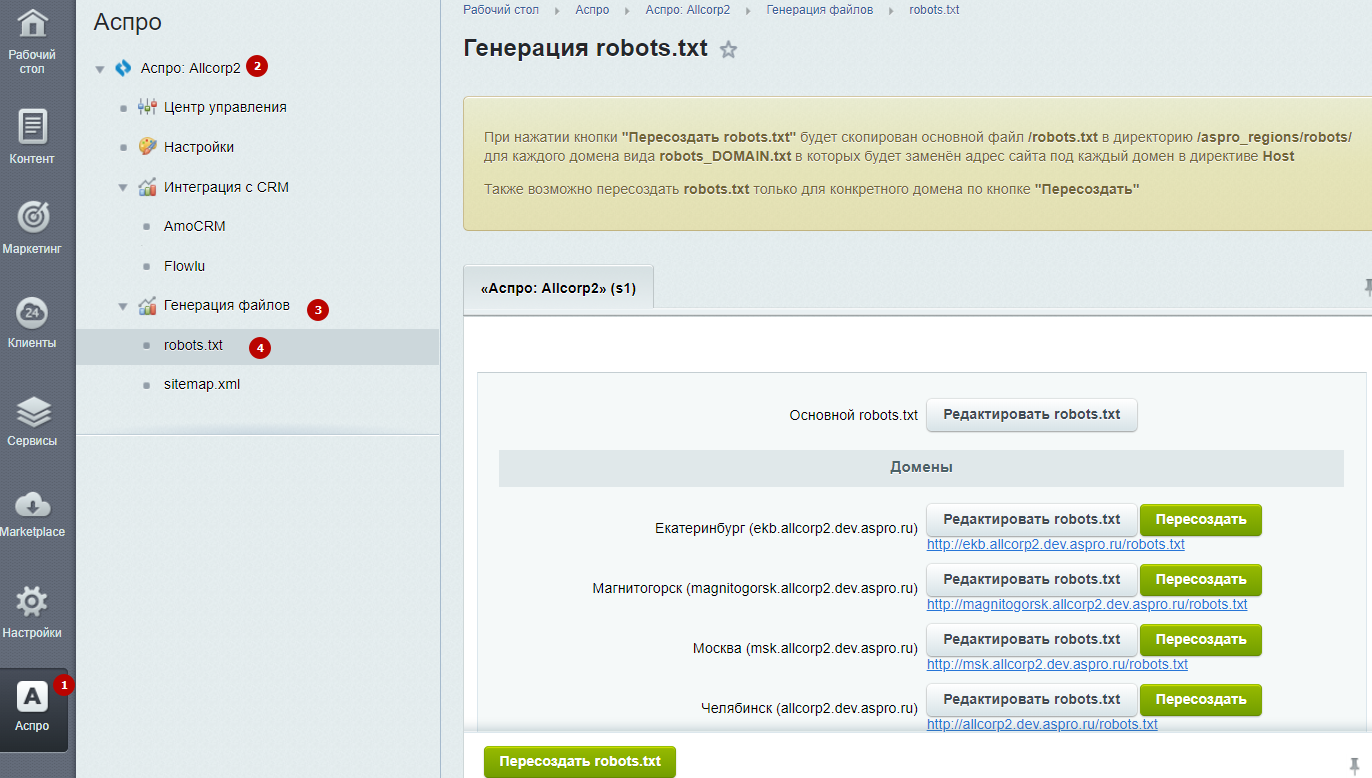

Чтобы воспользоваться автоматической генерацией robots.txt, перейдите в административной части сайта в Аспро (1) → Аспро: Allcorp2 (2) → Генерация файлов (3) → robots.txt (4). Включите региональность и выберите тип «на поддоменах» для возможности перегенерации robots.txt.

Используйте кнопку «Пересоздать robots.txt» для копирования основного файла robots.txt в директорию /aspro_regions/robots/ для каждого поддомена. Копии основного файла для поддоменов именуются по шаблону «robots_DOMAIN.txt». В каждой из них запись директивы Host будет изменена.

Также предусмотрена возможность пересоздания файла robots.txt только для конкретного поддомена. Для редактирования файла используйте одноименные кнопки.