- Описание курса

-

Редакции

- Аспро: Металл

- Аспро: Медицинский центр 3.0

- Аспро: Digital 2.0

- Аспро: Стройка 2.0

- Аспро: Инжиниринг

-

Аспро: Детский сад и образовательный центр

- Табы по разделам для услуг на главной странице

- Иконки материалов и добавление аудиофайлов в новостях

- Настройка вида отображения групп по возрасту

- Франчайзинг

- Расписание

- Универсальный виджет

- Выбор формы обратной связи для кнопок «Задать вопрос» и «Заказать услугу»

- Популярные товары с рекламным баннером в корне каталога

- Рекламный баннер в каталоге на главной

- Аспро: Курорт 2.0

- Аспро: Ландшафт 2.0

- Аспро: Автосервис

- Установка решения

- Виджет настроек решения

- Первые шаги

-

Общие настройки решения

- Версия для слабовидящих

- Карта сайта

- Блок «Поделиться»

- Атрибуты для пунктов меню, кнопок баннера и кнопки формы в шапке

- Универсальный виджет

- Настройки модуля решения

- Настройки оформления сайта

- Список телефонов

- Ссылки на страницы в социальных сетях

- Мультиязычность: переключение языков (сайтов)

- «Ленивая» подгрузка изображений — LazyLoad

- Валидация ввода

- Подключение Google reCAPTCHA

- Обработка персональных данных

- Настройки отображения кнопки «Наверх»

- Состав боковых иконок

- Не добавлять название сайта в заголовок браузера

- Переключение версий jQuery

- Подключение Yandex SmartCaptcha

- Кнопка «Скачать файл»

- Редактирование выпадающего списка контактов в шапке, футере и Мегаменю

-

Главная страница

- Управление расположением блоков на главной

- Большие баннеры на главной странице

- Тизеры преимуществ на главной

- Разделы каталога

- Элементы каталога на главной

- Баннеры с текстом на главной

- Блок «Акции» на главной

- Блок «Новости» на главной

- Баннеры картинками на главной

- Блок «Услуги» на главной

- Блок «Сотрудники» на главной

- Блок «Отзывы» на главной странице

- Баннеры с фоном на главной

- Блог на главной странице

- Блок «Проекты» на главной странице

- Блок «Галерея» на главной странице

- Блок «Карты» на главной странице

- Блок «Вопрос-ответ» на главной странице

- Блок «О компании» на главной странице

- Блок «Бренды» на главной странице

- Блок «Форма» на главной странице

- Виджет Instagram*

- Блок «ВКонтакте» на главной

- Блок «Тарифы» на главной

- Дополнительные блоки на главной

- Блок «Видеоотзывы» на главной странице

-

Каталог

-

Разделы и подразделы

- Настройки оформления

- Закрашивание SVG-иконок разделов в цвет темы

- Создание и настройка раздела каталога

- Настройка отображения описания в разделах каталога

- Свойство «Валюта» для микроразметки

- Настройка подстановки картинки раздела при отсутствии изображения товара

-

Карточка товара

- Настройки оформления карточки товара

- Создание и настройка товара

- Создание и настройка торгового предложения

- Создание комплектов

- Выбор типа SKU

- Настройка галереи в карточке товара

- Управление расположением блоков и табов в карточке товара

- Примечание-подсказка в карточке товара

- Примечание по цене в карточке товара

- Табы «Дополнительно», «Как купить», «Доставка» и «Оплата» в карточке товара

- Группировщик свойств Аспро

- Умный фильтр

- Параметр, определяющий SKU на детальной

- Массовая покупка товаров

- Настройка слайдпанели (галереи) в списке товаров

- Отображение характеристик при наведении на товар

- Сравнение товаров

- Отображение характеристик в табличном варианте

- Выражения и названия

- Сортировка по умолчанию в каталоге

- Быстрый заказ (в 1 клик)

- Настройка хлебных крошек

-

Разделы и подразделы

- Корзина

- Услуги

-

Основные разделы

- Галерея

- Статьи

- Новости

- Акции

- Проекты

-

Тарифы

- Настройки оформления

- Редактирование описания раздела «Тарифы»

- Создание и настройка разделов тарифов

- Создание и настройка тарифов

- Отображение тарифов без раздела

- Включение/отключение перехода в раздел и на детальную страницу тарифа

- Добавление пользовательского свойства в тарифах

- Добавление пользовательских периодов в тарифах

- Настройка сортировки предложений тарифа

- Партнеры

- Производители

- Отзывы в Аспро: Корпоративный сайт 3.0

- Сотрудники

- Вакансии

- Лицензии

- Документы

- Компания

- Контакты

- Свойства и связи

- Настройки шапки и меню

- Настройки футера

-

Мультирегиональность

- Настройка хостинга для региональности на поддоменах

- Обзор настроек

- Замена контактной информации на странице контактов в регионах

- Разделы и карточки регионов

- Автогенерация robots.txt

- Настройка Композитного сайта

- Название региона в заголовках и SEO-тегах

- Мультирегиональность – каждому региону свой контент

- Автозамена контента по регионам с помощью тегов

- Передача региональных переменных в почтовые шаблоны

- Настройка определения местоположения по Geo IP

- Система обратной связи

- Посадочные страницы

- Личный кабинет

- Мобильная версия

- SEO, маркетинг, реклама

- Интеграция с другими сервисами

- Требования к графическим материалам

- Для веб-разработчиков

- Установка модулей сторонних разработчиков

- Умный SEO

Автогенерация robots.txt

Файлы robots.txt и sitemap.xml – это самые важные для SEO-продвижения файлы сайта. В них содержатся команды для поисковых роботов. Благодаря им они понимают, какие страницы индексировать, а какие нет.

Эти файлы создаются администратором сайта. Подробности читайте в документации 1С-Битрикс:

Генератор robots.txt

Генерация файла карты сайта

Далее вам нужно сгенерировать эти же файлы для каждого региона. Обычно файлы robots.txt и sitemap.xml для различных регионов создаются, настраиваются и редактируются вручную. В Аспро: Корпоративный сайт 2.0 реализована возможность автоматической генерации файлов. Это принципиально новое решение задачи, которое позволит вам сэкономить время SEO-специалиста и сократить количество ошибок, которые возможны при ручном создании robots.txt и sitemap.xml под каждый регион. Рассмотрим, как работает этот функционал, и как с его помощью научиться автоматически генерировать нужные файлы.

После того, как вы создали файлы robots.txt и sitemap.xml для основного домена, инструкции из них можно продублировать в файлы, настраивающие доступ поисковых роботов к поддоменам. И здесь вам понадобится функция генерации файлов.

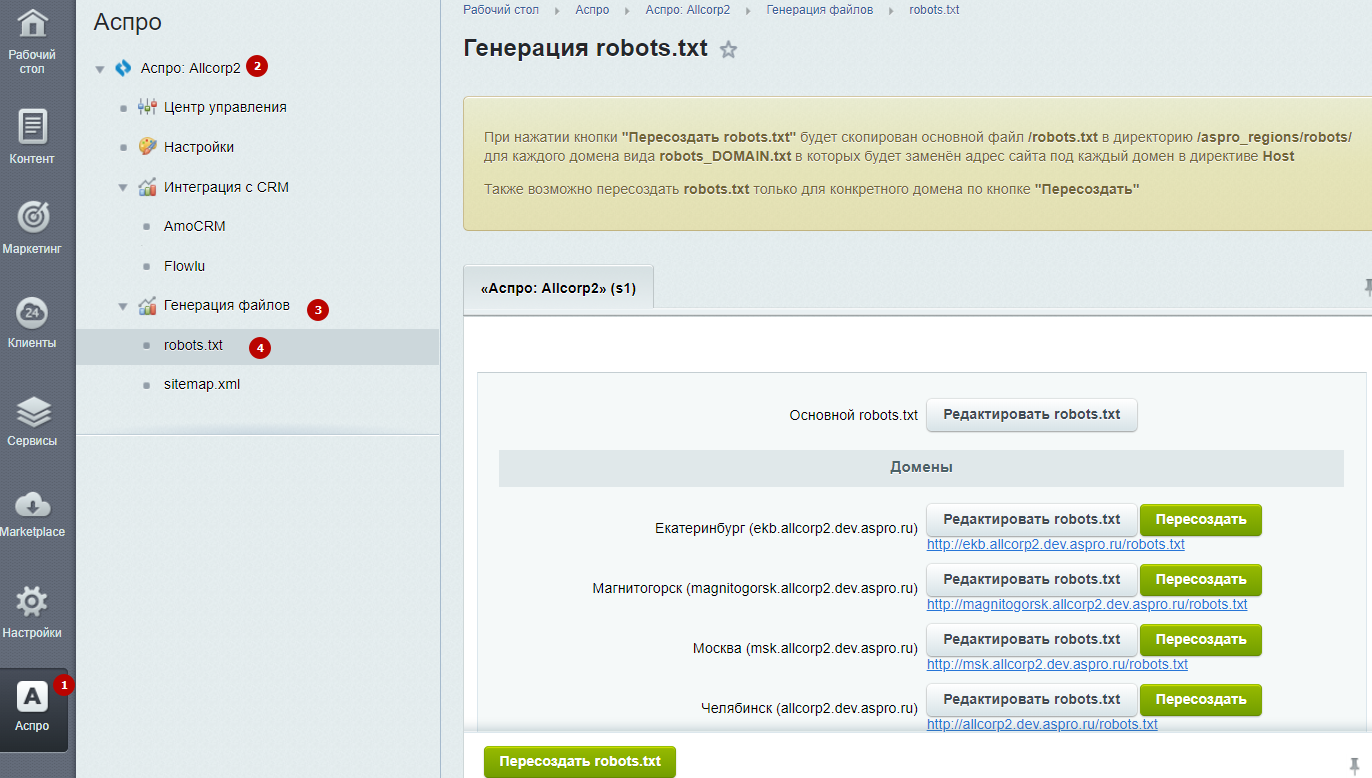

Чтобы воспользоваться автоматической генерацией robots.txt, перейдите в административной части сайта в Аспро (1) → Аспро: Allcorp2 (2) → Генерация файлов (3) → robots.txt (4). Включите региональность и выберите тип «на поддоменах» для возможности перегенерации robots.txt.

Используйте кнопку «Пересоздать robots.txt» для копирования основного файла robots.txt в директорию /aspro_regions/robots/ для каждого поддомена. Копии основного файла для поддоменов именуются по шаблону «robots_DOMAIN.txt». В каждой из них запись директивы Host будет изменена.

Также предусмотрена возможность пересоздания файла robots.txt только для конкретного поддомена. Для редактирования файла используйте одноименные кнопки.